Human Radiome Project

„ChatGPT für Mediziner:innen“

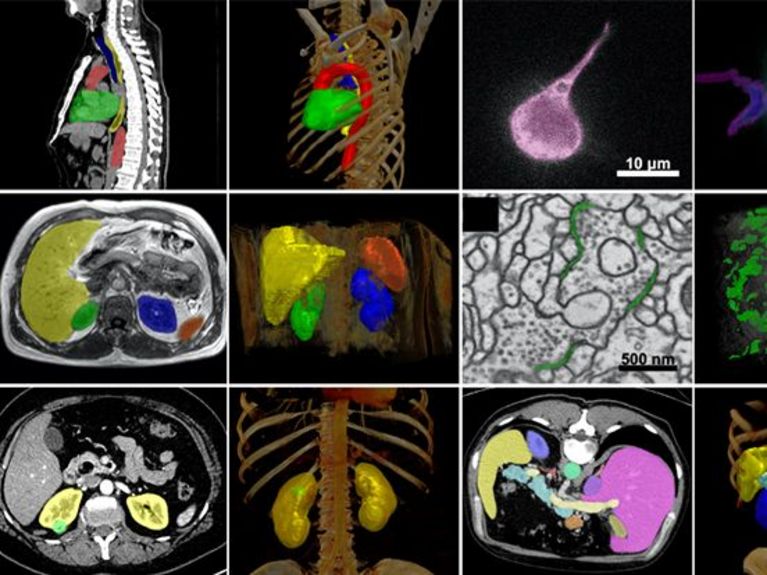

Bild: Fabian Isensee / DKFZ

Wie sieht ein Künstliche Intelligenz (KI)-Modell aus, das ganz unterschiedliche medizinische Fragestellungen mithilfe radiologischer Bilddaten beantwortet? Das Human Radiome Project soll genau dafür den Goldstandard setzen.

Mediziner:innen erkennen und überwachen viele Erkrankungen durch Bilder aus MRT- und CT-Untersuchungen – unter anderem verengte Herzgefäße, Hirntumore oder Alzheimer. Bei der Verarbeitung dieser wachsenden Bildfülle spielen KI-Modelle schon länger eine Rolle. Bis März 2024 waren 76 % aller zugelassenen KI-Anwendungen in den USA radiologische Applikationen.1

Bisher läuft das so: Ein KI-Modell soll eine ganz spezifische Aufgabe erfüllen, zum Beispiel Hirntumore erkennen. Für diese Aufgabe bekommt es möglichst viele und hochwertige Trainingsdaten. Die Trainingsdaten bilden die Grundlage der KI-Funktionalität und müssen dafür bis ins kleinste Detail von Expert*innen mit Erläuterungen versehen (annotiert) werden. Das kostet nicht nur viel Zeit und Geld; die Bilddaten stehen oft auch nicht in der benötigten Menge und Güte zur Verfügung.

Das Forschungsteam unter der Leitung von Paul Jäger, Klaus Maier-Hein, Fabian Isensee und Lena Maier-Hein vom Deutschen Krebsforschungszentrum (DKFZ) Heidelberg geht mit dem Human Radiome Project nun neue Wege: Sie trainieren ein radiologisches KI-Grundlagenmodell (Foundation Model), also ein Modell mit einem breitem Grundlagenwissen. Das bekannteste Foundation Model ist vermutlich Chat GPT. Allerdings basiert der Chat-Bot auf menschlicher Sprache und nicht auf radiologischen Bildern.

Mit dem so trainierten Modell sind dann Spezialisierungen möglich.„Wir hier in Deutschland legen mit dem Human Radiome Projektdie Basis für etwas, das gerade erst ins Rollen kommt“,so Klaus Maier-Hein.

Wir möchten Medizinern und Medizinerinnen schwierige Aufgaben erleichtern – dafür stellen wir gut funktionierende Tools bereit.

Die Trainingsdaten für das Foundation Model müssen nicht annotiert sein – das Modell lernt selbst, Strukturen in den Bildern zu erkennen und wird so zu einer Art Bild-Superhirn (siehe Kasten). Dazu braucht es aber eine Fülle an Daten. Das Team um das Human Radiome Project kann aus einem besonders reichen Fundus schöpfen: Sein Foundation Modell wird mit mehr als 4,8 Millionen 3D Bilddaten – MRT, CT und PET – vortrainiert. Mit 40x mehr Daten als bisher verfügbare Modelle 2 beinhaltet es damit das weltweit größte radiologische 3D Bilddatenset. „Diesen Fakt haben wir auch unserer guten Vernetzung zu verdanken“, sagt Klaus Maier-Hein. Neben der Menge an Bildern ist auch die 3-Dimensionalität wichtig, denn Anatomie und Pathologie sind dann am besten zu beurteilen. Die 3D-Bilddaten stammen vom DKFZ und von Partneruniversitäten in Bonn, Heidelberg und Basel, sowie aus verschiedenen öffentlich zugänglichen Datensätzen. „Je mehr und vielfältiger die Trainingsdaten, desto besser die Performance der KI in der realen Welt“, so Klaus Maier-Hein.

Auf der breiten Datengrundlage wird das Foundation Model anschließend auf mehr als 70 verschiedene Aufgaben spezialisiert – mit dem Grundlagenmodell lassen sich sozusagen ganz spezielle Fach-KI ausbilden. Dazu braucht man nur wenige, aber sorgfältig ausgewählte und annotierte Daten. Das Foundation Model soll unter anderem lernen, neurologische Erkrankungen zu analysieren, Hirntumore zu segmentieren und Krebsrisiken zu bestimmen. Hier liefern Industriepartner – Siemens Healthineers und FLOY GmbH – und weitere Partner der Helmholtz-Gemeinschaft wie das Deutsche Zentrum für Neurodegenerative Erkrankungen (DZNE) und das Max-Delbrück-Centrum für Molekulare Medizin (MDC) zusätzliche Daten. Spätere Nutzer können das vortrainierte Modell nutzen, um es mit wenigen eigenen Daten auf ihre spezifische Fragestellung abzustimmen.

Die Helmholtz-Forscher*innen stellen ihr Foundation Model als Open Source-Plattform zur Verfügung. „Es geht uns um einen Profit für die Community und um die Sichtbarkeit der Wissenschaft“, sagt Klaus Maier-Hein. Er hofft, dass verschiedene Anwender, auch Start-Ups, Lösungen für bestimmte medizinische Anwendungen mithilfe des Modells entwickeln. Vermarktung steht für das Team also nicht im Fokus, spätere Anwendungen dürfen aber gerne Geld verdienen – auf der Basis von Helmholtz geförderter Forschung.

Herausragende Forschungsergebnisse zu KI-Modellen haben die Forscher*innen vom DKFZ bereits geliefert.3 Ihre letzte KI-basierte biomedizinische Bildanalysenmethode gewann mehr als 30 internationale Wettbewerbe und genießt international hohe Anerkennung. Auch das neue Modell soll sein Können in öffentlichen Wettbewerben beweisen – beispielsweise ausgerichtet von genannten Medical Image Analysis Competitions (MICCAI).

Klinische Anwendungen: Was wird möglich? Was ist wichtig?

Das Human Radiome Project wird helfen, radiologische Diagnostik und medizinische Therapie zu verbessern: Krebsverläufe unter der Therapie beurteilen, seltene Erkrankungen entdecken, schwer auszumachende Auffälligkeiten finden. Denn das Modell erkennt auch für Menschen quasi unsichtbare Datenmuster. Sie können Zusatzinformation liefern und auf Erkrankungen hinweisen.

Ein KI-Modell schaut sozusagen unvoreingenommen auf ein MRT- oder CT-Bild: Es „sieht“ mehr als nur das zu untersuchende Organ. Ein Beispiel: Auf MRT-Bildern der Brust, wie sie in der Brustkrebsvorsorge angefertigt werden, ist auch die Aorta sichtbar. Vom Menschen beurteilt wird aber nur die Brust, denn es geht um Brustkrebsvorsorge. Ein KI-Modell kann auf beides spezialisiert sein, Brust und Aorta. „Die KI erkennt die Auffälligkeiten an der Aorta verlässlicher als ein Radiologe,“, so Klaus Maier-Hein.

Nützliche Krankheitsmerkmale

Die KI ist auch beim Einschätzen der Tumorgröße schneller und genauer als bisherige Methoden. Es kann Tumorgrenzen in 3D erkennen und so das Tumorvolumen berechnen; bei mehreren Untersuchungen im Zeitverlauf lässt sich also genaue Auskunft darüber geben, wie schnell der Tumor wächst – oder unter Behandlung schrumpft.

Am Beispiel der Tumoren zeigt sich besonders deutlich, wie wichtig die Zusammenarbeit zwischen IT und Medizin ist, um KI-Modelle richtig zu trainieren. Denn es geht nicht nur um die Größe. „Wir müssen wissen, was für Kliniker und Patienten entscheidend ist – und das ist neben dem Wachstum eines Hirntumors beispielsweise auch die Frage, ob es neue Herde gibt“, so Klaus Maier-Hein. Eine aktuelle Veröffentlichung des Teams beschäftigt sich genau damit: Welche Merkmale sind hilfreich und entscheidend für klinische Anwendungen?

Wenn die KI einen Hirntumor um 0,1 Prozent genauer vermisst als die Konkurrenz, sei dies zwar statistisch schön, gehe aber an der klinischen Fragestellung vorbei. Denn der genaue Durchmesser des Haupttumors ist für die Therapie des Patienten weniger entscheidend als die Existenz , eines neuen Tumorherds, und sei er noch so klein.

KI-Entwicklerinnen wie Paul Jäger, Klaus Maier-Hein, Fabian Isensee, Lena Maier-Hein und ihr Team werden die Medizin zusammen mit Künstlicher Intelligenz verändern.Mit dem Human Radiome Project eilt die Radiologie damit anderen Disziplinen voraus.

Was lernt das Foundation Model des Human Radiome Projektes?

Das Training von Foundation Models erfolgt mit immens großen Datenmengen. Bisher mussten die Daten für KI-Modelle auf kleinteiliger Ebene (pixel-level) annotiert sein. Die Annotierung musste manuell erfolgen. Dies erfordert, neben Expertise, Zeit und Geld. Ein KI-Modell auf dieser Basis ist dann hoch spezialisiert und eignet sich nur für sehr ausgewählte Szenarien. Seltene Erkrankungen konnten aufgrund der eingeschränkten Datenmengen gar nicht adressiert werden.

Das Foundation Model des Human Radiome Projects lernt auf Basis von Deep Learning ohne aufwändige manuelle Annotierungen. Es erkennt grundlegende Merkmale und Muster aus den Bildern von allein (selbstlernendes Modell) und erfindet eigene Annotierungen (Pseudo-Labels). Der Lernprozess beinhaltet unter anderem, Bilder korrekt zu ergänzen, denen absichtlich Stellen fehlen. Auch das Sprachmodell ChatGPT hat so gelernt: Mit Texten und Leerstellen, die der Algorithmus sinnvoll ergänzen sollte.

Beim Vortraining ist es wichtig, dass die Bilder von unterschiedlicher Qualität sind. Das KI-Modell muss mit allen Daten funktionieren. Wenn ein Modell nur mit hochwertigen Daten trainiert wird, funktioniert es nicht bei weniger hochwertigen Daten. "Einem Laien kann ich auch beibringen, Hirntumore zu erkennen. Das erlernte Spezialwissen funktioniert aber nicht mehr, sobald der Laie Bilder sieht, die mit einem anderen System oder anderen Einstellungen aufgenommen wurden. Er kann die Transferleistung nicht vollziehen“, erklärt Klaus Maier-Hein. Das Vortraining des DKFZ-Modells lässt sich grob mit dem Erfahrungsschatz eines Oberarztes oder einer Oberärztin vergleichen, die aufgrund ihrer Erfahrung Transferleistungen leichter vollziehen können.

Danach kann sich das Foundation Model auf bestimmte Fragestellungen spezialisieren. Für diese Feinabstimmung bekommt das Modell weitere, dieses Mal detailliert annotierte Bilddaten sowie medizinische Studiendaten aus der Bevölkerung und darüber hinaus Forschungsergebnisse.

Das Ergebnis: Die Darstellung, Erkennung und Einteilung verschiedenster Erkrankungen und ihrer Entstehung wird möglich. Das KI-Modell kann Diagnosen unterstützen, bei der Therapieplanung helfen, das Tumorwachstum bei Krebserkrankungen überwachen – je nachdem, auf was die Feinabstimmung abzielt.

Wieviel Energie braucht so das Foundation Model des Human Radiome Projektes?

Das Erlernen der Fertigkeiten des KI-Modells erfordert eine Menge Rechenpower: Die 4,8 Millionen 3D Bilddaten – MRT, CT und PET – entsprechen über 500 Terabytes (1 Terabyte ist ungefähr vergleichbar mit der Datenmenge von 200 Spielfilmen, 500 TB also mit der Datenmenge 100.000 Spielfilmen). Für die Bildverarbeitung und den maschinellen Lernprozess werden geschätzte 990.000 GPU - Graphics Processor Unit – Stunden und 4.000 CPU – Central Processing Units – Stunden eingeplant. Für diese enormen Rechenleistungen nutzt das Human Radiome Project den in Jülich stehenden Megarechner JUWELS.

1 Website der US Food&Drug Administration/US-Behörde für für Lebens- und Arzneimittel: Artificial Intelligence and Machine Learning (AI/ML)-Enabled Medical Devices. Besucht am 15.07.2024

2 Wang G, Wu J, Luo X et al. MIS-FM: 3D Medical Image Segmentation using Foundation Models Pretrained on a Large-Scale Unannotated Dataset. arXiv:2306.16925

3 Isensee F, Jaeger PF, Kohl SAA et al. nnU-Net: a self-configuring method for deep learning-based biomedical image segmentation. Nat Methods. 2021 Feb;18(2):203-211. https://doi.org/10.1038/s41592-020-01008-z

4 Maier-Hein L, Reinke A, Godau P et al. Metrics reloaded: recommendations for image analysis validation. Nat Methods. 2024 Feb;21(2):195-212. doi.org/10.1038/s41592-023-02151-z

Helmholtz Foundation Model Initiative

Bei den sogenannten Foundation Models handelt es sich um eine neue Generation von KI-Modellen, die eine breite Wissensbasis haben und deshalb in der Lage sind, eine Reihe von komplexen Problemen zu lösen. Sie sind deutlich leistungsstärker und flexibler als herkömmliche KI-Modelle und bergen somit ein enormes Potenzial für die moderne, datengetriebene Wissenschaft. Sie können mächtige Werkzeuge werden, die eine Vielzahl von Forschungsfragen beantworten. Die Helmholtz-Gemeinschaft bringt ideale Voraussetzungen mit, um solche zukunftsweisenden Anwendungen zu entwickeln: eine Fülle an Daten, leistungsstarke Supercomputer, auf denen die Modelle trainiert werden können, und eine tiefgreifende Expertise im Bereich der künstlichen Intelligenz. Unser Ziel ist es, Foundation Models über ein breites Spektrum von Forschungsfeldern hinweg zu entwickeln, die zur Lösung der großen Fragen unserer Zeit beitragen.

Leser:innenkommentare